Folge 4 - Technik

Zehn Jahre Bildbeschaffer - und mit zehn Artikeln beleuchten wir die einzelnen Aspekte unseres Schaffens. Heute: Technik. Aber wie langweilig für Sie wäre ein Rückblick. Wir müssten daran erinnern, dass vor genau zehn Jahren die erste Facebook-Seite in deutsch erschien - aber noch keine Mobile-Version, denn das iPhone war ja auch erst seit ein paar Monaten auf dem Markt. Wir könnten über Flickr schreiben, die vor 10 Jahren dick mit Getty Images im Geschäft waren und die Privat-Fotografen zu Stock-Fotografen machten - und natürlich: Vor 10 Jahren haben sich die Billig-Anbieter wie Fotolia und Shutterstock fest etabliert, Getty kaufte vor 10 Jahren istockphoto.

Wenden wir uns mit diesem Artikel lieber den nächsten 10 Jahren zu. Und da sind Insights spannend von jemandem, der seine Finger am Puls hat. Deshalb als Highlight das Interview mit Florian Meissner, einem der Gründer von EyeEm, dem derzeit wohl spannendsten technischen Hotspot der Szene!

Das Interview mit Florian Meissner führte Jana Kühle.

„YouTube für professionelle Fotos", „Marktplatz für Fotografie", „globale Bilder-Community" – die Beschreibungen von EyeEm sind vielfältig. Für jemanden, der euch noch gar nicht kennt: Was verbirgt sich hinter eurem Unternehmen?

Florian Meissner: Im Herzen verstehen wir uns als Plattform für Fotografen. Wir wollen kreativen Menschen, die ein Auge für Bilder haben, Tools an die Hand geben, ihnen dabei helfen, sich auszudrücken und die nächste Stufe ihrer Karriere zu erreichen. Wie werde ich besser? Welche meiner Bilder kommen an? Wie kann ich damit Geld verdienen? Das sind Fragen, mit denen sich unsere Nutzer beschäftigen. Wir haben ein technologisches Fundament aufgebaut, einen Marktplatz, der Kunden dabei hilft, Bilder und mittlerweile auch Videos zu finden und zu kaufen. Den Verkaufserlös teilen wir uns 50:50 mit den Fotografen.

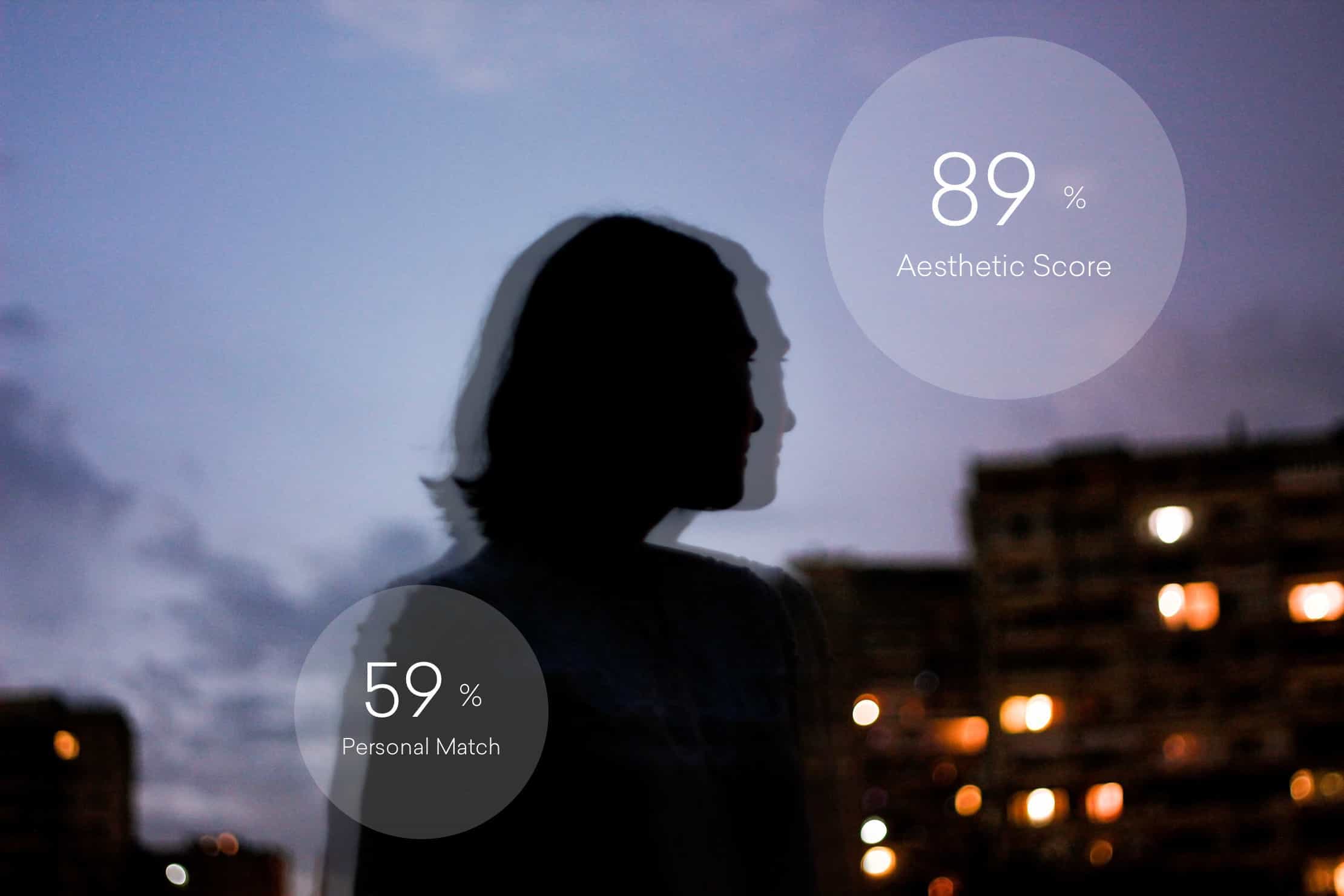

Im Herzen steht eine Technologie, die automatisch erkennt, was im Bildmaterial, das wir bekommen, zu sehen ist – ob das jetzt die Bremer Stadtmusikanten sind oder auch ein Sonnenuntergang. Wir können auch Mutmaßungen darüber treffen, ob ein Bild qualitativ gut genug ist. Das ermöglicht uns, nicht nur Hunderte oder Tausende von Bildern täglich zu durchforsten, sondern Millionen von Bildern – mit einer innovativen Echtzeitsuche, die sogar personalisiert und auf den Kundengeschmack abgestimmt werden kann.

Das Gründer-Team: Gen Sadakane, Florian Meissner, Lorenz Aschoff und Ramzi Rizk

Gestartet seid ihr 2011 als 10-Personen-Team in Berlin, heute fasst euer Unternehmen etwa 75 Mitarbeiter. Wie seid ihr überhaupt auf die Idee gekommen, EyeEm zu gründen?

Ich habe mir 2010 im Alter von 25 Jahren einen großen Traum erfüllt, bin nach New York gegangen und habe als Fotograf für ein Magazin in Brooklyn gearbeitet. Nach nur einem Monat wurde ich überfallen: Mein komplettes Equipment war weg. Aus der Not heraus habe ich ein Smartphone als Kamera benutzt, ohne dass es jemandem aufgefallen ist. Kurz darauf habe ich ein Buch mit meinen Handybildern veröffentlicht und einer meiner Mitgründer hat es gekauft– so sind wir in den Austausch gekommen. Uns war bewusst, dass die Qualität der Geräte immer besser wird und dass da eine ganz neue Bildwelt entsteht, auf die sich die üblichen Anbieter da draußen überhaupt nicht konzentriert haben. Eine Bildwelt, die sich nicht vergleichen lässt mit der üblichen Stockfotografie. Es sind keine gestellten Familienbilder oder Business-Fotos, sondern Bilder, die authentisch sind und mitten aus dem Leben kommen. Das hat uns fasziniert. Allerdings hatten wir schnell ein Problem: Wir haben dermaßen viele Bilder bekommen, dass wir sie nicht manuell durchforsten konnten. Wir wollten keine Keywording-Agentur in Indien anheuern, wie es heute oft üblich ist. Stattdessen haben wir uns vor einigen Jahren darauf spezialisiert, den Prozess, die Suche und das Auffinden von visuellem Bildmaterial zu automatisieren. Wir haben ein sehr starkes Fotografie-Team, das Hand in Hand mit dem Algorithmus arbeitet. Dadurch können wir brauchbare Bilder viel schneller herausfiltern. Eine Reise, die mittlerweile schon über sieben Jahre dauert.

Welche technologische Entwicklung war für dich in den vergangenen Jahren die einschneidendste?

Da sehe ich ganz klar zwei Trends: einmal die Erfindung des Smartphones mit integrierter Kamera, die den Kompaktkameramarkt kaputt gemacht haben. Und dann die verschiedenen Technologien, die sich an Maschinen hängen, in unserem speziellen Fall Computer Vision, also eine Subform der künstlichen Intelligenz, die es schafft, Bilder automatisch zu kategorisieren und zu filtern. Das hat vor fünf Jahren an Speed aufgenommen. Rechenpower und Handyprozessoren sind besser und die Bandbreiten schneller geworden. Wir waren eines der ersten Unternehmen weltweit, die das erkannt, ein Team aufgebaut und Technologien entwickelt haben, die sich darauf konzentriert haben. Das sind die beiden Aspekte, die es überhaupt erst ermöglicht haben, dass es uns gibt.

Stichwort deep learning: Wer bei euch als Fotograf die App runterlädt, muss die Bilder nicht mehr selber verschlagworten oder Hashtags vergeben. Ihr bietet automatisch die richtigen Tags an und der Nutzer muss sie nur bestätigen. Wie bringt ihr der Technik bei, überhaupt etwas auf den Bildern zu erkennen?

Das sieht einfach aus, im Hintergrund stecken aber mehr als drei Jahre harter Arbeit. Was wir da letztlich machen: Wir kreieren künstliche, neuronale Netzwerke. Wenn du zum Beispiel einem Algorithmus beibringen willst, wie er ein Skateboard erkennt, musst du erst mal ein sogenanntes manuelles Trainingsset an Skateboardbildern haben, zum Beispiel 1.000 Stück. Wir bekommen ja Tausende von Bildern, die wir auf dieses Trainingsset schmeißen, aber es sind vielleicht nur zwei neue Skateboardbilder dabei. Der Algorithmus funktioniert ähnlich wie das menschliche Auge: Je mehr Bilder ich von einem Skateboard sehe, desto besser kann ich es als solches erkennen. Der Algorithmus arbeitet mit der Zeit immer schneller und akkurater.

Ihr füttert den Algorithmus also jeden Tag.

Ja, jede Sekunde. Und dann haben wir den Schritt gewagt, uns auf Kriterien zu konzentrieren, die dabei helfen, ein Bild inhaltlich zu beschreiben. Zum Beispiel auf Schönheit, auf Symmetrie. Wir wissen beispielsweise, dass die Farbe Rot in Japan beliebter ist und in Brasilien eher die Farbe Braun. Wenn also jemand in Brasilien ein Auto sucht, schicken wir ihm natürlich zunächst braune, den Japanern rote Autos. Die Bilderkennung wird so akkurat, dass es fast schneller und besser funktioniert als das menschliche Auge.

Ehrlich? Führt das nicht dazu, dass uns ein Algorithmus irgendwann vorschreibt, was wir schön zu finden haben? Wo bleibt da Raum für den Kunden, der mit einem speziellen, ganz persönlichen Bildgeschmack auf euch zukommt?

Genau diese Frage haben wir uns Anfang 2017 auch gestellt. Wie kommen Marken auf uns zu, die andere als die von uns angebotenen Bilder suchen? Wir wollen ja überhaupt nicht Gott spielen und entscheiden, was schön ist, sondern wir wollen unseren Algorithmus der Visual Identity eines Unternehmens, einer Marke oder eines Magazins anpassen können. Nehmen wir das Beispiel der BCG, der Boston Consulting Group. Sie hatte erkannt, dass alle Beratungsseiten gleich aussehen und sie durch visuelle Differenzierung einen Premium-Markeneffekt erzielen können. Bei den üblichen Bildagenturen haben sie nichts gefunden, was ihrem Anspruch genügte. Also haben wir gemeinsam mit unserer Community eine Bildsprache entwickelt, die der Marke BCG entspricht und die auf dem Trainingsset von ein paar Tausend Bildern basiert. Wir haben unseren Algorithmus so angepasst, dass die Bilder zur Marke passen. Mittlerweile nutzen die weltweit 11.000 Berater unsere Bilder und können sie über ein PowerPoint-Plug-in in ihre Präsentationen einbauen.

Man kann die Algorithmen also auch so trainieren, dass sie personalisiert werden.

Ja, wir nennen das einen Markenfilter. In diesem Filter befinden sich dann nur Bilder, die zu der jeweiligen Marke oder dem jeweiligen Nutzerprofil passen.

Letztlich kann ein Algorithmus aber ja nur darauf zurückgreifen, was ohnehin schon existiert und womit man ihn speist. Nach dem Motto: Dieses Bild gefällt euch, also wird euch auch jenes Bild gefallen. Wo ist da Raum für Innovation und Wandel in Sachen Bildgeschmack? Ein Algorithmus kann ja nicht visionär sein, oder?

Momentan glauben wir, dass das, was wir gerade anbieten – wir nennen das eine personalisierte Suche – genau das ist, was der Markt braucht. Die Kosten für ein Bild oder Videos setzen sich ja nicht nur aus den Lizenzkosten zusammen, sondern auch aus der Zeit, die man braucht, um das Bild zu finden. Da sind wir ja schon sehr innovativ. Es gibt ein Feld, dass sich generative künstliche Intelligenz nennt. Sie kann irgendwann mal so weit sein, dass zum Beispiel Bilder publiziert werden. Nehmen wir ein Beispiel: Jemand sagt, er braucht ein Bild von Rio, auf dem eine Palme zu sehen ist. Dann kann er sich verschiedene Bilder zusammenstellen – beispielsweise ein Bild von einem Strand, eines von einer Palme und eines von einem Pärchen – und sie zusammenfügen. Das Geld wird dann an die drei Fotografen bezahlt, die an dem Bild mitgewirkt haben. Ich kann mir vorstellen, dass das in einigen Jahren möglich sein wird. Insofern werden wir immer versuchen, uns am Puls der Zeit weiterzuentwickeln. Im Moment sind wir noch sehr darauf fokussiert, Mensch und Maschine zusammenzubringen und unseren Workflow zu verbessern.

Wenn wir jetzt alle die von dir erwähnten Aspekte berücksichtigen: die Daten über die verkauften Bilder, die euch zeigen, was gerade auf dem Markt gefragt ist, die länderspezifisch unterschiedlichen Nachfragen und die Erkenntnisse über den persönlichen Geschmack wie im Beispiel der Boston Consulting Group – würdest du sagen, Ästhetik lässt sich tatsächlich messen?

Gute Frage. Künstliche Intelligenz versucht ja, den Menschen so gut es geht nachzuahmen und das wird je nach Datenlage auch immer besser. Wenn es um die Bildersuche für einen Menschen oder eine Marke geht, sind wir schon sehr gut darin, zu lernen, was gesucht wird und welche Vorschläge passend sind. Das ist ein konstanter Prozess, der mit jedem verkauften Bild optimiert wird. Dementsprechend haben wir sehr viele Informationen darüber, was als qualitativ hochwertig eingestuft und genutzt wird. Wir bedienen aber ja einen kommerziellen Markt und wollen uns nicht anmaßen, zu sagen, was kulturell oder gesellschaftlich schön ist. Ich denke aber schon, dass Algorithmen da in Zukunft sehr nah herankommen werden. Wir kooperieren gerade mit dem koreanischen Handyhersteller LG. Seit Ende Februar verbessern wir die Camera Roll von ihren Handys. Du kannst damit die Bilder deines Smartphones nach bestimmten Kriterien durchsuchen. Die Suchen werden immer besser und an deinen ganz persönlichen Geschmack angepasst. Es wird spannend, wohin die Reise geht.

Ist euch das kein zu großer Eingriff in die Privatsphäre der einzelnen Nutzer?

Uns ist das Thema Privatsphäre sehr wichtig. Die Software der App läuft auf dem Telefon selber, also auf dem Speicherplatz des Geräts. Wir nehmen keine Daten raus. Alles das, was der Nutzer eingibt oder auch jedes Tag, das wir vorschlagen, muss der Nutzer bestätigen bzw. freigeben. Das ist schon eine andere Denkweise als die von Google oder Facebook. Da bringen wir einen ganz anderen Wertekosmos mit. Unsere Kunden schätzen sehr, dass wir in Deutschland sitzen und nach deutschem Recht arbeiten und die Themen Privatsphäre und Datenschutz professionell handhaben.

Ihr habt auch schon ein Magazin herausgegeben. Kommt das tatsächlich ganz ohne menschliche Bildredakteure aus und wird komplett durch Algorithmen gelayoutet?

Gelayoutet nicht, aber die meiste Kurationsarbeit versuchen wir tatsächlich mit unserem Algorithmus zu lösen. Es gibt ein kleines Team um einen Fotokurator und natürlich den Algorithmus. Das Magazin erscheint zurzeit einmal im Quartal.

Wo liegen momentan die Grenzen der Algorithmen? Vor welchen Herausforderungen seht ihr euch momentan oder auch künftig?

Ich denke da in erster Linie an das Thema anderer Formate wie beispielsweise Videos, 3D-Inhalte oder Technologien wie Augmented Reality oder auch Virtual Reality. Das sind spannende Themenfelder, wo andere Art von Bildmaterial benötigt wird. Dahingehend wollen wir uns gern auch verbessern und mit der Community wachsen. Dann haben wir als Unternehmen natürlich auch unternehmerische Herausforderungen: dass wir zum Beispiel international wachsen wollen. Damit haben wir zurzeit erstmal genug zu tun. Unsere Community ist in Amerika und Asien sehr stark gewachsen. In Deutschland geht es gerade erst los, dass wir bekannter werden.

Bleiben wir bei der Zukunftsmusik: Welche Industrien können durch diese Art der Bilderkennung über den Bildermarkt hinaus künftig gestärkt werden? Ich denke da an den Security-Bereich, an die Medizin oder auch an die Verkehrssicherheit.

Genau. Wir sind davon überzeugt, dass die statische Bildsuche, die bei Google oder auch bei Bildagenturen momentan angeboten wird, kaputt ist. Und wir glauben, dass personalisiert werden muss. Wie cool wäre es, wenn wir beispielsweise sagen könnten: Ich würde jetzt gern Bilder in New York durch die Augen von Kira Pollack finden, der Bildchefin vom TIME Magazine oder von Justin Bieber in L.A. oder auch von dem berühmten Fotografen Martin Parr in London. Das wird irgendwann möglich sein: dass wir mithilfe von Software in Zukunft viel einfacher Bilder nach bestimmten Vorgaben finden können. Ich könnte dann zum Beispiel schauen: Was für ein Bild sollte ich auf Facebook posten, um als Marke die meisten Likes zu bekommen, wenn ich in Japan an eine Zielgruppe zwischen 16 und 21 herankommen will.

Stimmt es, dass ihr mal ein berühmtes Bild von Henri Cartier-Bresson durch den Algorithmus geschickt habt, mit dem Ergebnis: ästhetisch nur mittelmäßig?

Ja, genau darauf will ich hinaus: Wie kannst du einem Algorithmus auch Cultural Heritage beibringen oder dass es sich – wie bei Cartier-Bressons Pfützenspringer – um eines der wichtigsten Bilder der Fotografiegeschichte handelt? Momentan sind wir sehr fokussiert auf die kommerziellen Bilder. Ich hoffe aber, dass wir noch sehr viele Jahre arbeiten und auch Aspekte wie diesen weiterentwickeln können.

Herzlichen Dank für das Gespräch!

Wenn Sie möchten, einmal pro Monat als Magazin per Email.

Weitere News:

-

Swiss Photo Club

Monday, 11.03.2024 | Agentur des Monats

Mit der Leiterin des Swiss Photo Club verbindet uns nicht nur der nächste LinkedIn Audio Talk.

Weiterlesen...

Lesen Sie hier: Was, wann und wo! -

10. April: Präsenz-Schulung in Hamburg

Monday, 11.03.2024 |

Nach fünf Jahren so lebendig wie nie zuvor: Unsere Präsenz-Seminare starten wieder!

Auftakt in Hamburg - los geht´s!

Weiterlesen... -

28. März: Webinar KI in der Bildwelt

Monday, 11.03.2024 |

Die dringlichsten Fragen beantworten wir jeden Monat im Webinar: Was geht? Was darf? Können wir Midjourney & Co. professionell einsetzen? Was spricht dagegen? Und: Welche Tools gibt es noch?

Weiterlesen...

Nächster Termin: 28. März! Jetzt buchen! -

Transformation steht auf der Agenda!

Tuesday, 09.01.2024 | Thema des Monats

2023 war das Jahr der Veränderung. Voller Energie starten wir und - das hoffen wir sehr - Sie auch!

Es tut sich viel. Und das möchten wir mit Ihnen teilen.

Weiterlesen...